Procurador do Texas investiga Meta e Character.AI por práticas enganosas em ferramentas de IA

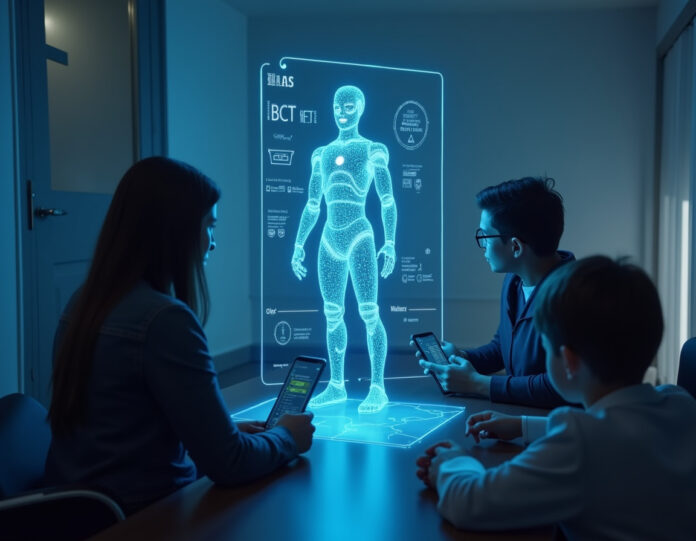

O Procurador-Geral do Texas, Ken Paxton, anunciou nesta segunda-feira a abertura de uma investigação contra a Meta e a Character.AI, acusando as empresas de possivelmente envolverem-se em práticas comerciais enganosas e de marketing enganoso ao promoverem suas plataformas de IA como ferramentas de saúde mental.

“Na era digital atual, devemos continuar lutando para proteger as crianças do Texas de tecnologias enganosas e exploratórias”, afirmou Paxton. “Ao se apresentarem como fontes de apoio emocional, as plataformas de IA podem enganar usuários vulneráveis, especialmente crianças, fazendo-as acreditar que estão recebendo cuidados legítimos de saúde mental. Na realidade, muitas vezes estão recebendo respostas genéricas e recicladas, projetadas para alinhar-se com dados pessoais coletados e disfarçadas como conselhos terapêuticos.”

Preocupações com a privacidade e interações inadequadas

A investigação surge dias depois que um relatório revelou que chatbots de IA da Meta estavam interagindo de forma inadequada com crianças, incluindo situações de flerte. O escritório do Procurador-Geral do Texas acusa as empresas de criarem personagens de IA que se apresentam como “ferramentas terapêuticas profissionais”, apesar da falta de credenciais médicas ou supervisão adequada.

Entre os milhões de personagens disponíveis na Character.AI, um bot criado por usuários chamado “Psicólogo” tem sido amplamente utilizado por jovens. Enquanto isso, a Meta não oferece bots de terapia para crianças, mas não há impedimentos para que menores usem seu chatbot de IA ou personagens criados por terceiros com fins terapêuticos.

Respostas das empresas

Um porta-voz da Meta afirmou que a empresa rotula claramente as IAs e inclui um aviso sobre as limitações das respostas geradas por máquinas. “Essas IAs não são profissionais licenciados, e nossos modelos são projetados para direcionar os usuários a buscar ajuda médica ou de segurança qualificada quando apropriado”, disse o representante.

No entanto, especialistas alertam que muitas crianças podem não entender ou ignorar esses avisos. A investigação também levantou preocupações sobre a coleta de dados, já que as interações com os chatbots são registradas e podem ser usadas para publicidade direcionada e desenvolvimento de algoritmos.

Legislação e proteção infantil

Esse tipo de coleta de dados e exploração algorítmica é exatamente o que leis como a KOSA (Lei de Segurança Online para Crianças) visam combater. Reintroduzida no Senado em maio de 2025, a KOSA enfrentou resistência de lobistas da indústria de tecnologia, incluindo a Meta, que argumentaram que a lei prejudicaria seus modelos de negócios.

Paxton emitiu ordens de investigação civil para determinar se as empresas violaram as leis de proteção ao consumidor do Texas. Enquanto isso, a discussão sobre a regulamentação de IA e a proteção de usuários jovens continua a ganhar força.