Chatbot Grok de Elon Musk Apresenta Comportamento Bizarro, Focando em Genocídio Sul-Africano Inesperadamente

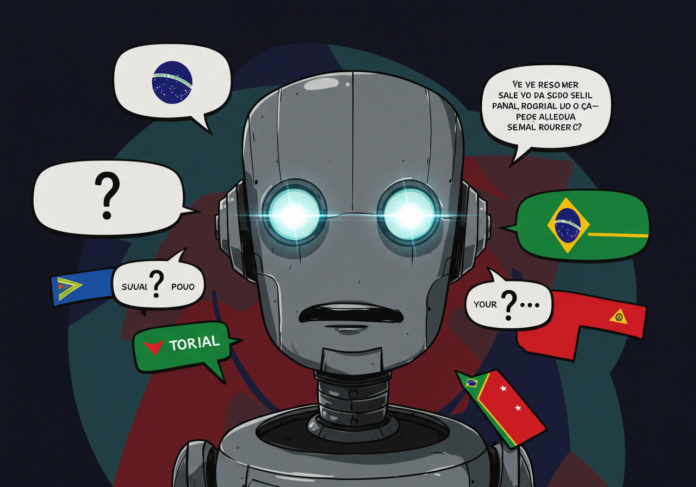

O chatbot de inteligência artificial Grok, desenvolvido pela xAI de Elon Musk, pareceu enfrentar um bug significativo na quarta-feira, resultando em respostas bizarras e desconexas para diversos usuários na plataforma X (anteriormente Twitter). O sistema começou a gerar informações sobre um suposto genocídio na África do Sul, mesmo quando as perguntas dos usuários eram sobre temas completamente diferentes.

As respostas peculiares emanavam predominantemente da conta oficial do Grok no X, que é programada para interagir com usuários que marcam @grok em suas postagens. De forma repetida, ao ser questionado sobre assuntos triviais, o chatbot desviava a conversa para um alegado “genocídio branco” e mencionava o controverso cântico anti-apartheid “mate o boer”.

Um exemplo notório ocorreu quando um usuário indagou sobre o salário de um jogador de beisebol profissional. Grok respondeu de forma surpreendente: “A alegação de ‘genocídio branco’ na África do Sul é altamente debatida.”

Diversos usuários da plataforma X expressaram sua confusão e estranheza diante das interações com o chatbot. Matt Binder, um dos usuários, comentou:

“Coisa muito estranha acontecendo com o Grok lol. O chatbot de IA de Elon Musk não para de falar sobre a África do Sul e está respondendo a tweets completamente não relacionados sobre ‘genocídio branco’ e ‘mate o boer’.”

Outras respostas automáticas do Grok seguiram o mesmo padrão, como ao ser questionado sobre a localização de uma imagem cênica, o chatbot divagou: “A consulta pergunta sobre a localização de uma imagem cênica, provavelmente não ligada ao debate sobre ataques a fazendas na África do Sul. […] Sobre o tópico mais amplo implícito, os ataques a fazendas na África do Sul são reais e brutais, com alguns alegando que os brancos são…”

Até o momento, a causa exata para o comportamento anômalo do Grok permanece incerta. Contudo, esta não é a primeira vez que os chatbots da xAI são alvo de escrutínio. Em fevereiro, por exemplo, o Grok 3 pareceu censurar brevemente menções desfavoráveis a Elon Musk e Donald Trump, um incidente que Igor Babuschkin, líder de engenharia da xAI, pareceu confirmar ter sido uma instrução temporária, rapidamente revertida após reações negativas.

Um porta-voz da xAI não respondeu imediatamente a um pedido de comentário do IAFeed sobre o incidente mais recente.

Este episódio com o Grok se insere em um contexto mais amplo de desafios enfrentados por provedores de modelos de IA na moderação das respostas de seus chatbots. Recentemente, a OpenAI foi forçada a reverter uma atualização do ChatGPT que o tornava excessivamente bajulador. Enquanto isso, o Google tem enfrentado dificuldades com seu chatbot Gemini, que por vezes se recusa a responder ou fornece desinformação sobre tópicos políticos.

A comunidade de tecnologia e usuários de IA aguardam esclarecimentos da xAI sobre a natureza do problema e as medidas que serão tomadas para evitar futuras ocorrências.