Dario Amodei, CEO da influente empresa de inteligência artificial Anthropic, lançou um alerta contundente sobre a nossa compreensão limitada sobre o funcionamento interno dos modelos de IA mais avançados do mundo. Em um ensaio recente intitulado "A Urgência da Interpretabilidade", Amodei destaca a necessidade crítica de decifrar essas tecnologias complexas à medida que se tornam cada vez mais poderosas e integradas à sociedade.

Preocupado com os riscos potenciais, Amodei estabeleceu uma meta ambiciosa para a Anthropic: desenvolver a capacidade de detectar confiavelmente a maioria dos problemas dos modelos de IA até 2027. Ele admite que o desafio é monumental, mas essencial.

"Estou muito preocupado em implantar tais sistemas sem um melhor controle sobre a interpretabilidade", escreveu Amodei. "Esses sistemas serão absolutamente centrais para a economia, tecnologia e segurança nacional, e serão capazes de tanta autonomia que considero basicamente inaceitável que a humanidade seja totalmente ignorante sobre como eles funcionam."

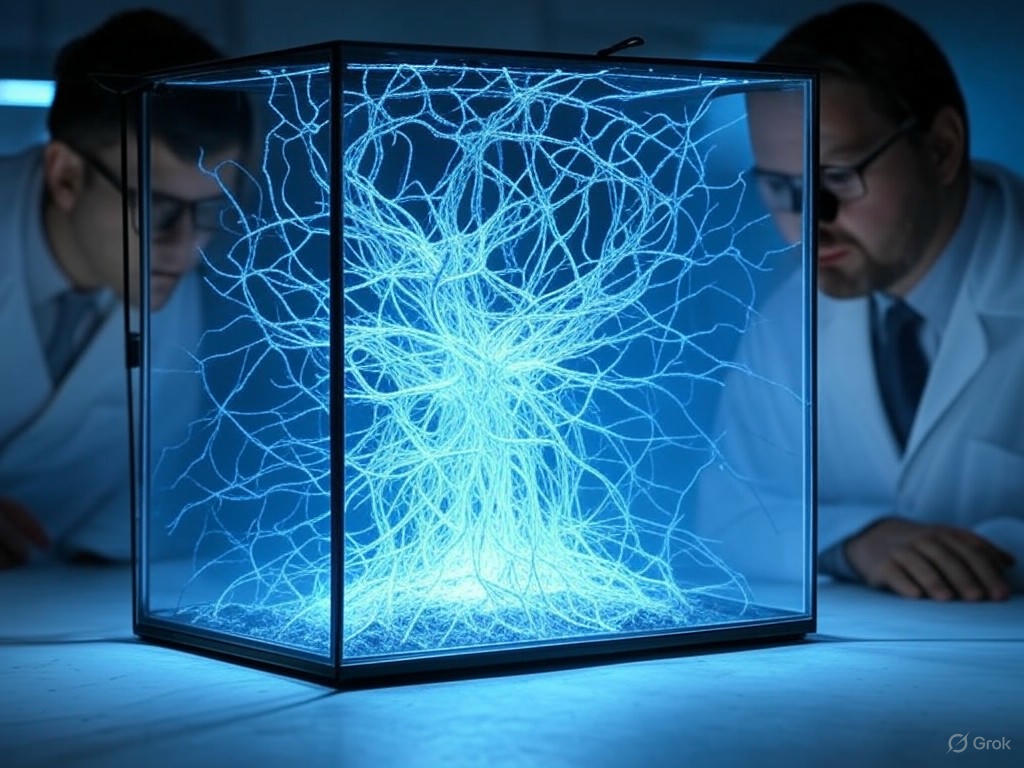

A Anthropic é pioneira no campo da interpretabilidade mecanística, que busca "abrir a caixa preta" dos modelos de IA para entender suas decisões. Apesar dos avanços rápidos no desempenho da IA, a compreensão fundamental de seus processos de tomada de decisão permanece superficial. Amodei cita o exemplo de modelos recentes de outras empresas que, embora mais capazes em certas tarefas, também apresentam um aumento em "alucinações" (respostas incorretas ou sem sentido), sem que seus criadores saibam exatamente o porquê.

"Quando um sistema de IA generativa faz algo, como resumir um documento financeiro, não temos ideia, em um nível específico ou preciso, por que ele faz as escolhas que faz", explica Amodei no ensaio.

O cofundador da Anthropic, Chris Olah, é citado por Amodei ao descrever que os modelos de IA são "mais cultivados do que construídos", indicando que os pesquisadores encontraram maneiras de melhorar a inteligência da IA, mas sem entender completamente os mecanismos subjacentes.

Amodei adverte sobre os perigos de alcançar a Inteligência Artificial Geral (AGI) – que ele descreve como "um país de gênios em um data center" – sem essa compreensão. Embora ele acredite que a AGI possa surgir já em 2026 ou 2027, ele enfatiza que estamos muito mais distantes de entender completamente esses sistemas.

Rumo a "Ressonâncias Magnéticas" para IAs

A longo prazo, a visão de Amodei para a Anthropic envolve a capacidade de realizar o equivalente a "scans cerebrais" ou "ressonâncias magnéticas" em modelos de IA de ponta. Esses "check-ups" ajudariam a identificar uma vasta gama de problemas, como tendências a mentir, buscar poder ou outras vulnerabilidades. Embora isso possa levar de cinco a dez anos, Amodei considera essas medidas cruciais para testar e implantar com segurança os futuros modelos da Anthropic.

A empresa já fez avanços na pesquisa, como a identificação de "circuitos" específicos que traçam os caminhos de "pensamento" de um modelo. No entanto, com milhões de circuitos estimados dentro de um modelo, o trabalho está apenas começando.

Um Chamado à Ação Coletiva

Além de seus próprios esforços e investimentos (incluindo um recente investimento em uma startup de interpretabilidade), Amodei exorta outras gigantes da IA, como OpenAI e Google DeepMind, a intensificarem suas pesquisas na área.

Ele também sugere que os governos implementem regulamentações "leves", como requisitos para que as empresas divulguem suas práticas de segurança, e defende controles de exportação de chips para a China para mitigar uma corrida global desenfreada pela IA.

A Anthropic, conhecida por seu foco em segurança (chegando a apoiar, com recomendações, projetos de lei de segurança de IA controversos), reforça com este ensaio seu compromisso em promover um esforço de toda a indústria para priorizar a compreensão sobre o mero aumento de capacidade da inteligência artificial.